近日,数据空间科学研究中心在垃圾邮件检测领域取得了一项重要研究成果,该研究通过应用参数高效混合专家模型(Parameter-Efficient Mixture of Experts,PEMoE)和设计动态专家分配算法,实现了计算资源消耗低同时性能强大的垃圾邮件检测。经过大量的实验,所取得的研究成果发表在2nd International Conference on Machine Intelligence and Digital Applications(MIDA2025)。

研究背景

随着社交网络的普及,邮件成为人们交流的重要方式。但同时大量的攻击者通过制造垃圾邮件攻击网络,危害了用户隐私和网络安全。检测垃圾邮件对于网络安全十分重要。之前的研究方法已在垃圾邮件检测领域取得进展,但仍有局限性。机器学习方法在垃圾邮件检测上有着较好性能,但其泛化性低,预训练语言模型拥有强大的检测性能和泛化性,但计算资源消耗大,对于个人难以负担。因此,寻找计算资源消耗低的训练方法对垃圾邮件检测来说是亟待解决的问题。

技术方案

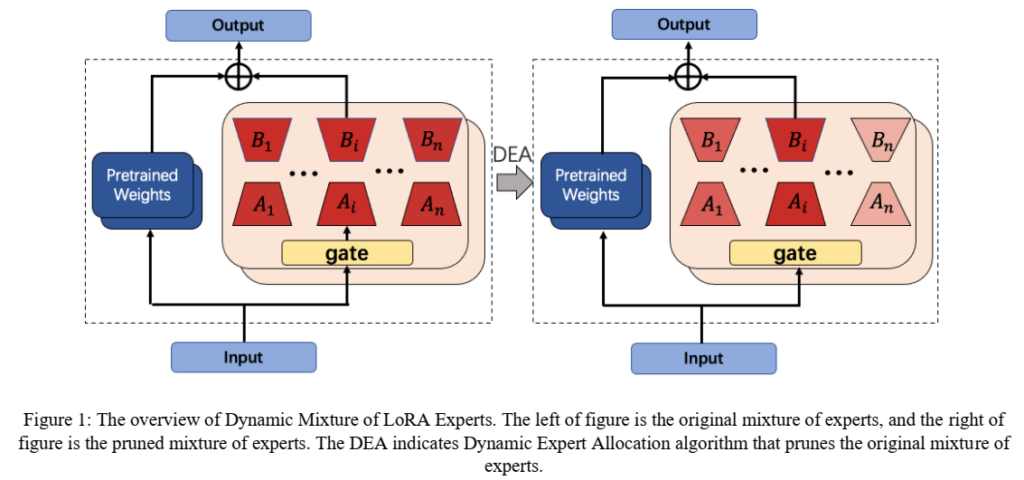

为解决上述问题,研究人员提出了动态混合LoRA专家模型(Dynamic Mixture of LoRA Experts, DMoLE)。在模型框架中,选择了门控网络为top-1线性网络和LoRA作为专家的混合LoRA专家模型,同时设计了动态专家分配算法(Dynamic Expert Allocation, DEA),通过分析专家在训练过程中的重要性,为专家分配合适的参数预算。

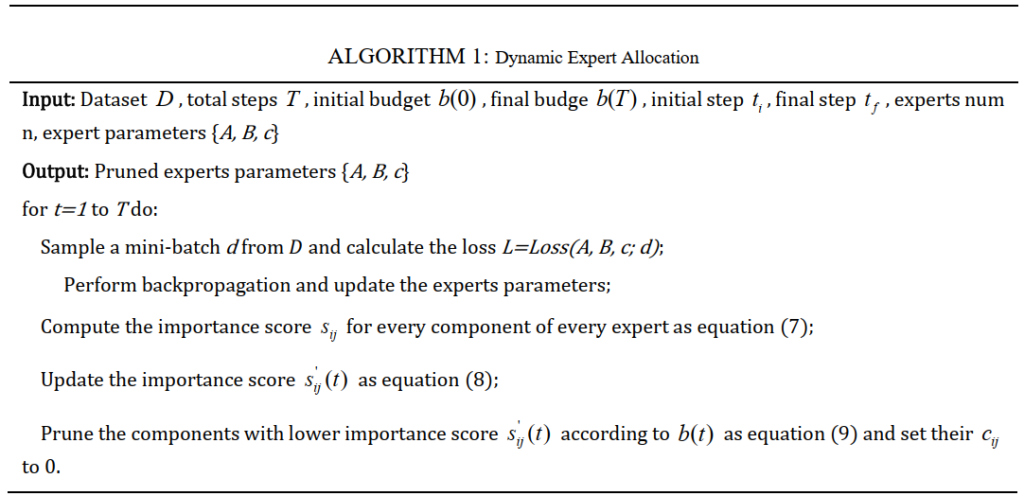

动态专家分配算法首先将LoRA专家分解为r个秩为1的组成部分,同时加入剪枝向量。在训练时,根据组成部分的范数除以整个LoRA专家的范数来得到该组成部分的重要性分数,之后对重要性分数进行平滑,然后根据训练步数得到当前步数的总参数预算,平滑重要性分数低于当前总参数预算对应的阈值的部分将被剪枝,从而实现LoRA专家的参数预算动态分配,降低专家的参数冗余。

实验结果

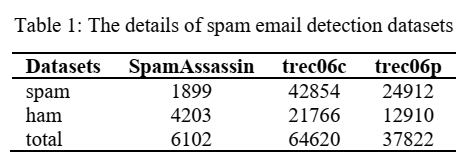

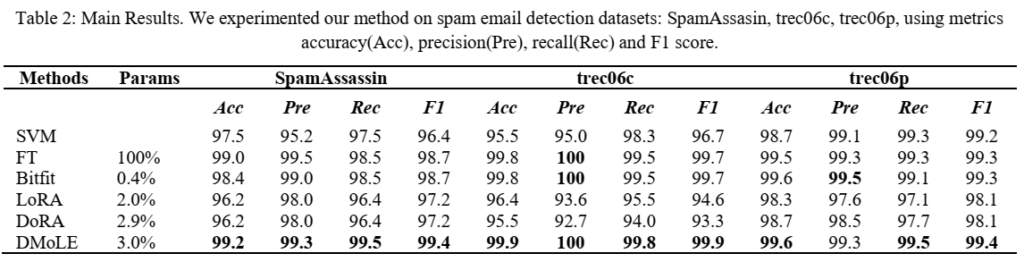

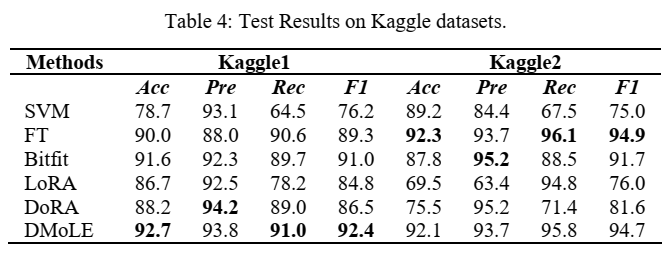

研究人员在SpamAssassin和TREC06两个数据集上检测了动态混合LoRA专家模型性能,以及在两个网页数据集Kaggle1和Kaggle2上检测其泛化性。

实验结果表明,动态混合LoRA专家模型在各数据集上都具有接近甚至略优于全参数微调的性能,而其仅微调3.0%的模型参数。同时,其检测性能强于Bitfit、LoRA及DoRA这三个参数高效微调方法,动态混合LoRA专家模型能有效提高LoRA的性能。同时,动态混合LoRA专家模型拥有较强的泛化性,其在Kaggle1及Kaggle2上,各项指标均接近于全参数微调。另外对比于LoRA,其泛化性能提升显著,在Kaggle1及Kaggle2上,其准确率分别提升了5.0%及22.6%。

研究人员进行了动态专家算法的消融实验,实验结果表明,动态专家分配算法在数据量较少时,可帮助混合LoRA专家模型提高性能,证明动态专家算法能够降低专家参数冗余,在数据量较多时,动态专家分配算法不会因为剪枝降低模型性能。